Страница неизвестна роботу яндекса что делать

Страница обходится роботом, но отсутствует в поиске. Ошибка Яндекс.Вебмастер

Что за ошибка?

Это означает, что робот посетил её, но не удосужился внести её в поисковую выдачу, сочтя её некачественной и вообще — вы спамер, у вас много рекламы, исправляйте всё немедленно, а потом поговорим! Самое удивительно то, что «некачественным» он иногда считает материал по 5000-10 000 знаков копирайта и отличным положением у конкурента в поиске (у меня не проиндексированная страница в Я была в ТОП-3 в G)

Симптомы:

Устраняем ошибки, которые указаны в разделе «Диагностика»

Чтобы повысить качество сайта и страниц в глазах Яндекса, нужно, как это ни странно, воспользоваться советами его самого. Дело в том, что в Я.Вебмастере в разделе «Диагностика» есть список текущих ошибок, которые вполне могут повлиять на выдачу

Что конкретно нужно исправить и как это сделать?

Воспользоваться инструментом «Переобход страниц»

В Яндекс. Вебмастере есть специальный сервис, заставляющий робот заново посетить вашу страницу «Инструменты» — «Переобход страниц». Заставьте робота еще раз посетить вашу страницу. Идеальный вариант — немного добавить контента или хотя бы поменять где-то текст. В общем, видоизмените страницу, на которую будете ссылаться.

Удалить дубли, запретить их к индексации

Как видите страниц с редиректом пруд пруди:

Самое интересно то, что еще одним стандартным сервисом «Яндекса» дубли не удалить сходу: Пишет ошибку «Нет основание для удаления». Т.е. яндекс не может просто убрать страницу с поиска, если даже вы этого хотите. Ему нужны основания

Для того, чтобы перестали генерироваться дубли и для того, чтобы их можно было удалить с поисковой выдаче нужно проделать следующие шаги

Обычно этот файл находится в директории с названием вашей темы. Для редактирования можете использовать FTP ну или встроенный редактор в админке WP — это на ваше усмотрение. Вставляем следующий код

remove_action(‘wp_head’, ‘wp_shortlink_wp_head’);

Чтобы запретить индексацию дублей нужно создать соответствующее правило в файле robot.txt

Т.е. страницы вида «site.ru/?p» запрещены к индексации. Кстати, на Word Press проще всего добавить это правило также через код в том же файле functions.php. Результат удаления URL через Я.Вебмастер теперь положительный:

Создать карту сайта (Sitemap)

Карта сайта создана специально для упрощения навигации не только пользователей, но и поисковых роботов. Поэтому, если вы считаете, что вашем посетителям она ни к чему, то сделайте её хотя бы для поисковой системы. Давно доказано — файл Sitemap улучшает индексацию страниц и сайта в целом! Для того, чтобы создать файл Sitemap.xml в CMS Word Press используйте плагин «Google XML Sitemaps».

Чтобы показать Яндексу, что файл у вас создан и может использоваться роботом в Я.Вебмастере зайдите в «Настройка индексирования» — «Файлы Sitemap» и вставьте ссылку на неё (учтите, что статус «Очередь на обработку будет висеть достаточно продолжительное время»)

Заполнить мета тэг name description

Чтобы не заморачиваться с правкой кода, мы можем использовать плагин для Word Press — Meta Tag Manager, который добавляет в конце редактора специальный контейнер, где можно его вписать

Пишем в техническую поддержку Яндекса

Если уверены в качестве своего сайта и конкретно тех страниц, которые не попадают в поиск. У Яндекса довольно большой мануал и огромные список того, «чего не желательно» или вовсе «нельзя». Советуем ознакомиться, перед тем, как строчить кляузу — https://yandex.ru/support/webmaster/yandex-indexing/webmaster-advice.xml

Что можно и где нужно писать, чтобы мне ответили?

Итак, вы уверены, что ваш сайт белый и пушистый, поэтому вам срочно нужно написать в Яндекс. Если это действительно так, то:

После чего откроется форма для обратной связи с техподдержкой:

В сообщении можете написать примерно следующий текст (не копируйте его полностью, просто используйте как шаблон)

Вышеуказанные страницы отсутствуют в результатах выдачи. Проверка URL через сервис Webmaster.Yandex.ru показала статус «Страница обходится роботом, но отсутствует в поиске» В разделе, который указан для профилактики таких случаев (Некачественные сайты) не нашел ничего, чтобы относилось к моему сайту. Контент на страницах уникальный, рекламы на сайте нет, другие страницы сайта индексируются нормально.

Что было дополнительно сделано (перечисляете всё, что пытались сделать, если следовали нашей статье, то текст ниже можно не менять)

— Запрещены к индексации дубли и удалены с помощью инструмента («Удалить URL»). Точнее там были не дубли, а страницы с ошибкой переадресации (HTTP 301 MOVED PERMANENTLY).

— Сделана карта сайта (site.ru/sitemap.xml)

— Добавлен мета тэг description на все записи в блоге

— Использован инструмент «Переобход страниц».

Укажите, пожалуйста, причину непопадания этих страниц в поисковую выдачу.

P.S. Ответ от Яндекса — это просто ошибка инструмента «Проверка URL»

Техническая поддержка Яндекса ответила мне на удивление быстро. Оказалось, мои страницы-таки были в поиске — во всём виноват кривой инструмент «Проверить URL». Я.Вебмастер совсем недавно выкатил новую версию этого сервиса — видимо, пока что, не всё работает, как задумано.

Т.е. возможно страницы есть, а может и нет? Чтобы точно убедится в том или ином предположении, нужно проверить наличие в индексе на других сервисах для веб-мастеров.

Где проверить есть ли эти страницы в индексе?

Можно с помощью сервиса pr-cy.ru. Там можно даже не регистрироваться или авторизовываться лишний раз. Просто введите адрес URL в строку «Анализ сайта», а затем нажмите на число страниц напротив строки «Яндекс».

Далее откроется страница Яндекса со специальным поисковым запросом, где будут отображены все ваши проиндексированные страницы:

Каков результат?

Через неделю после вышеописанных методов количество страниц в поиске увеличилось на 50% — это при том, что дубли и некачественные страницы, которые были в поиске были удалены! И это всего по прошествии одного апдейта выдачи!

Страница обходится роботом, но отсутствует в поиске — как добавить сайт в поиск Яндекса?

Средний 1 комментарий

Эх, вспомню, когда работал км/маркетологом :).

Проверить, что сейчас находиться в индексе можно набрав в поисковой системe site:<название сайта>:

Это самый базис, который надо делать сразу после снятия запрета на индексирование. Дальше уже можно смотреть в сторону турбо-страниц и amp, создание микроразметки (op, schema).

robots не делал т.к. он нужен для закрытия страниц от интексации, насколько я понимаю.

Неправильно понимаете. Не буду копировать определение из гугла, если простыми словами: «этот файл нужен для того, чтобы объяснить поисковым роботам что можно индексировать, а что индексировать нельзя. Сам же файл файл состоит не только из одной директивы disallow, там есть и другие 🙂

sitemap нареканий со стороны яндекса.вебмастер не вызывает (добавил уже). Что посоветуете дописать?

Совет один, ознакомиться с рекомендациями составить правильно два файла. После этого проверить робот.тхт на ошибки, а сформированную карту сайта добавить в соответствующий раздел.

10 основных причин, по которым страница сайта может не находиться в индексе поисковых систем Яндекс или Google

Причина номер 1. Новая страница или новый сайт

Первая причина, это то, что поисковые роботы еще просто не нашли новую страницу вашего сайта. В зависимости от того, какой ваш сайт, переобход страниц может занимать от нескольких минут до нескольких недель.

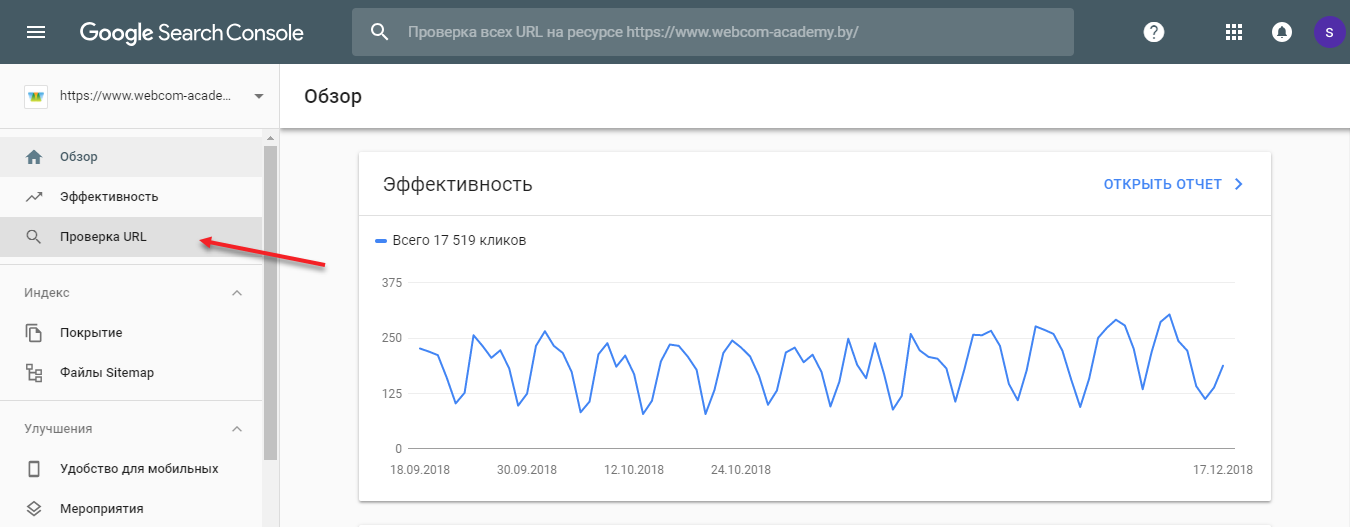

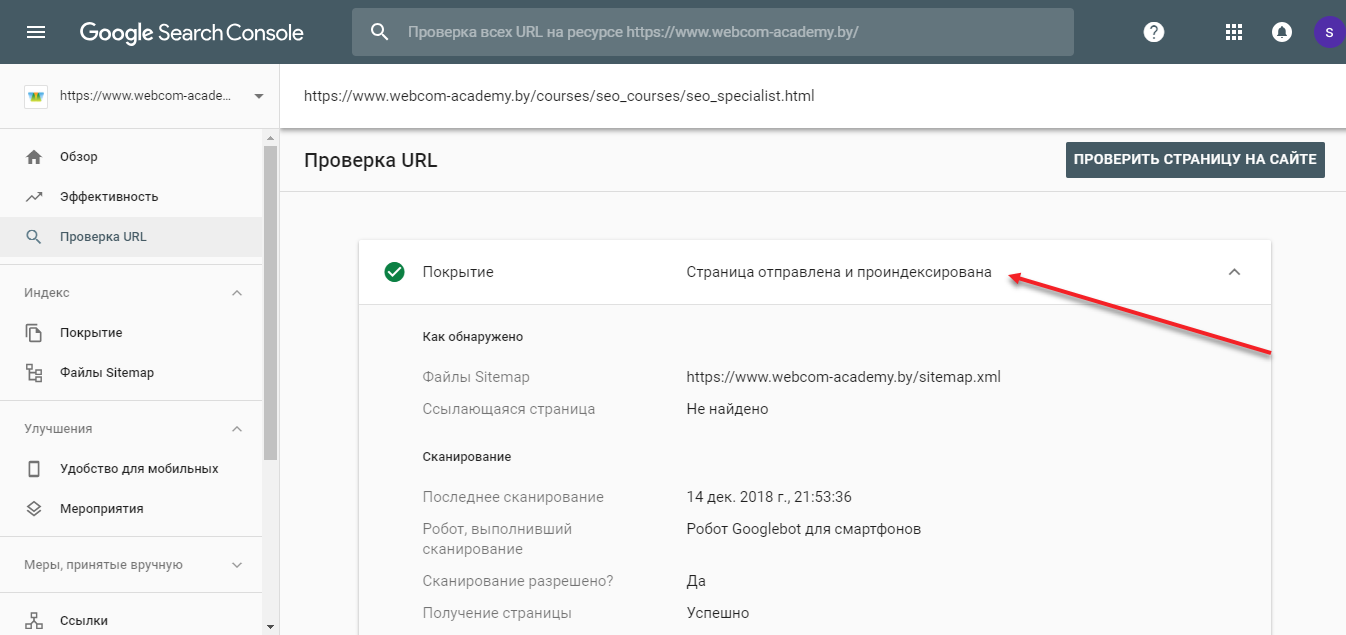

Чтобы узнать, находится ли в индексе страница Вам необходимо воспользоваться сервисами вебмастера Яндекс или Google Search Console.

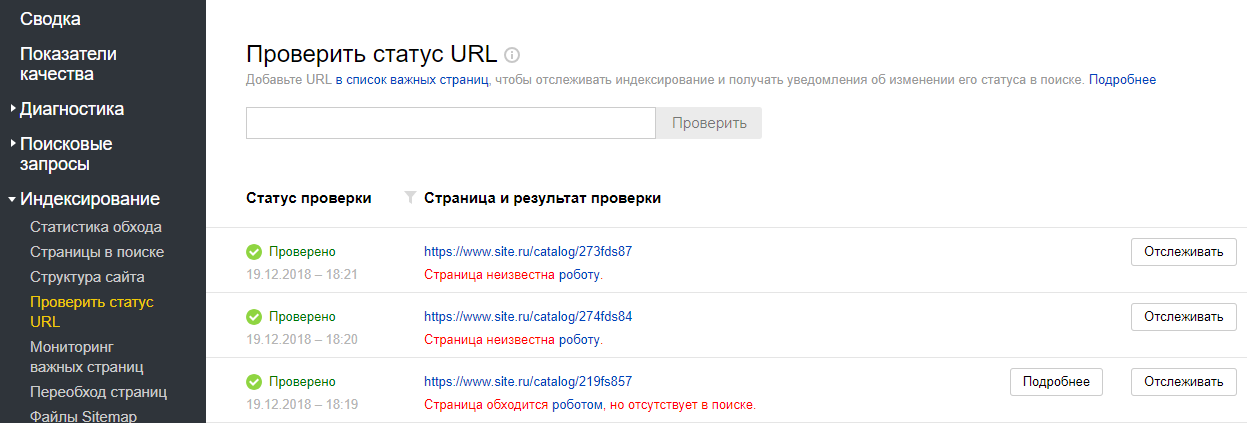

Если робот о странице еще не знает, вы увидите сообщение «Страница неизвестна роботу».

В новой версии Google Search Console вам нужен инструмент «Проверка URL». Если робот обошел и проиндексировал страницу, вы увидите уведомление «URL есть в индексе Google».

Если робот на странице еще не был, вы увидите сообщение «URL нет в индексе Google».

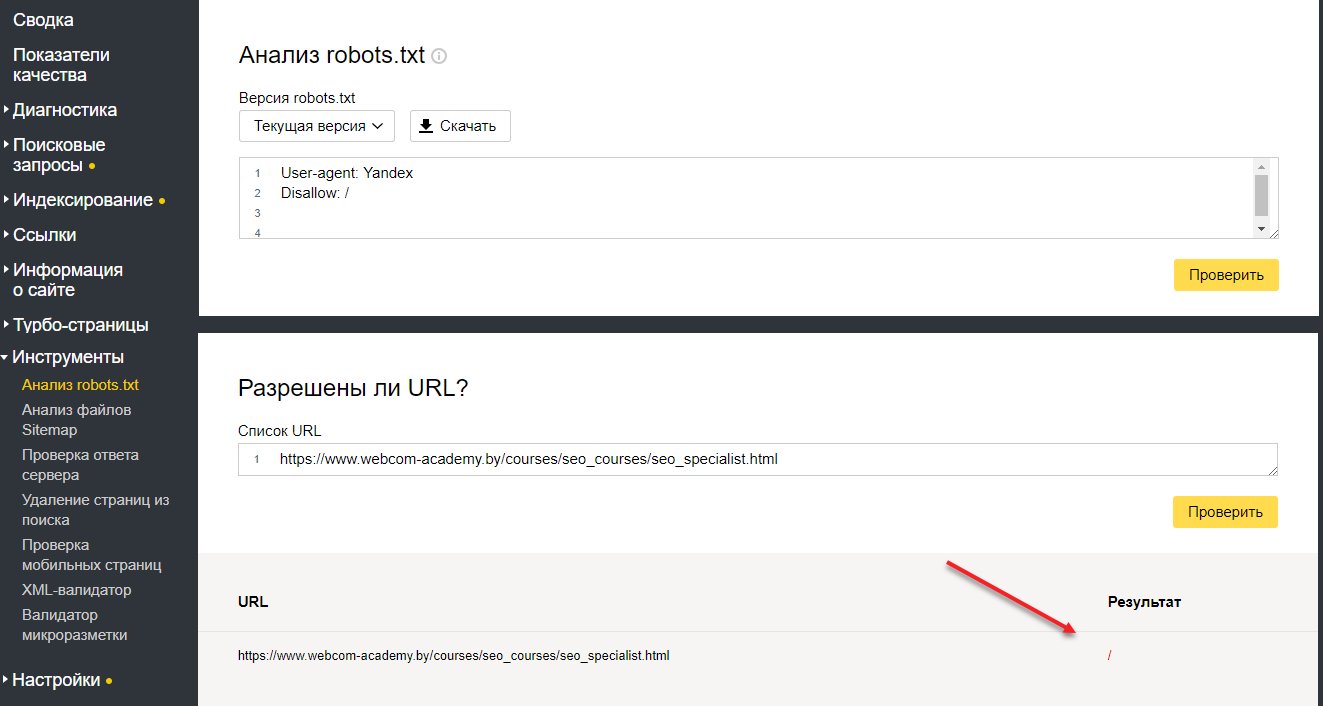

Причина номер 2. Страница или сайт закрыты от индексации в файле robots.txt

Существует специальный файл robots.txt, который позволяет указать роботам на то, какие страницы сайта должны быть в индексе поисковых систем, а какие страницы не должны быть включены.

Соответственно, если в файле прописаны запрещающие правила, в индексе поисковых систем данную страницу вы не найдете.

Как проверить, закрыта ли страница в robots.txt?

Важно! На данный момент эта вкладка находится в старой версии вебмастера!

Причина номер 3. Указан запрет в User-Agent

У поисковых систем есть свои требования к тому, как должен строиться файл robots.txt. И начинается он с приветствия. Приветствие может быть обращено к роботу яндекс, либо гугл, либо к обеим поисковым системам.

Часто для Яндекс и Google делают отдельные секции в файле robots.txt. А потом забывают вносить правки в эти секции. Из-за этого роботы потом некорректно начинают индексировать сайт.

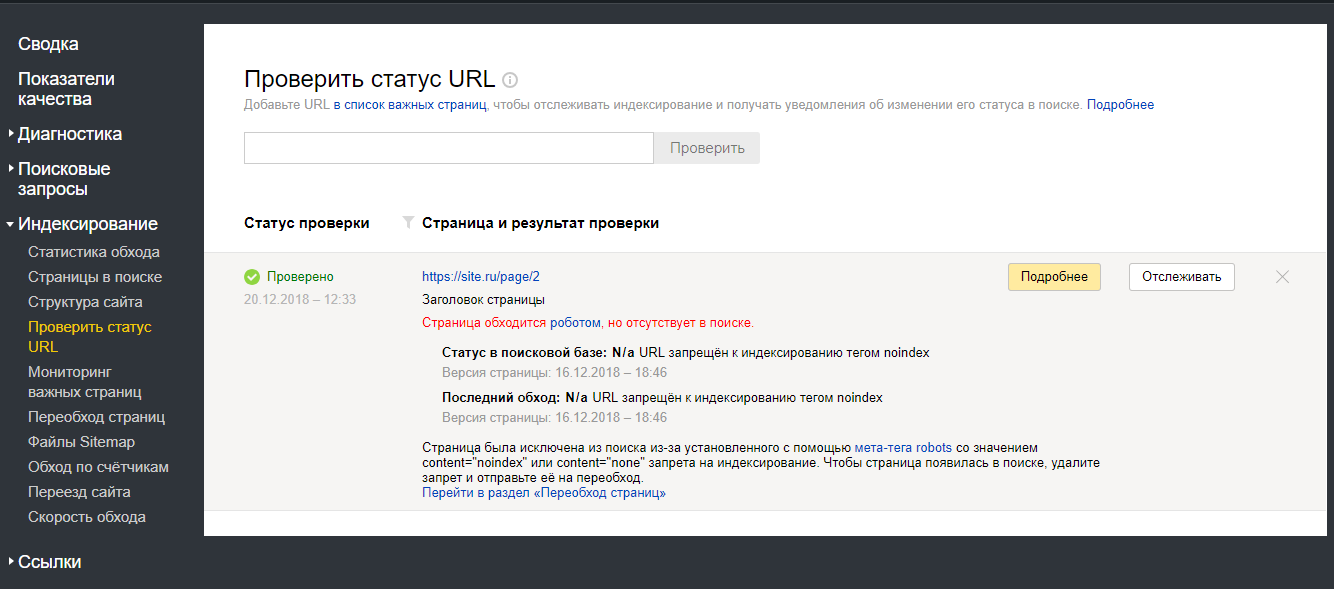

Причина номер 4. Запрет на индексацию страниц указан в мета-теге robots.

Суть этого мета-тега такая же, как и у файла robots.txt, только если страница закрыта в robots.txt она все равно может быть проиндексирована поисковыми системами. Но если на странице используется noindex или none, страница не будет добавлена в индекс.

1. Проверить использование данного мета-тега на странице можно в коде (сочетание клавиш Ctrl+U)

2. С помощью дополнения для браузера, например seo meta

3. С помощью вебмастеров.

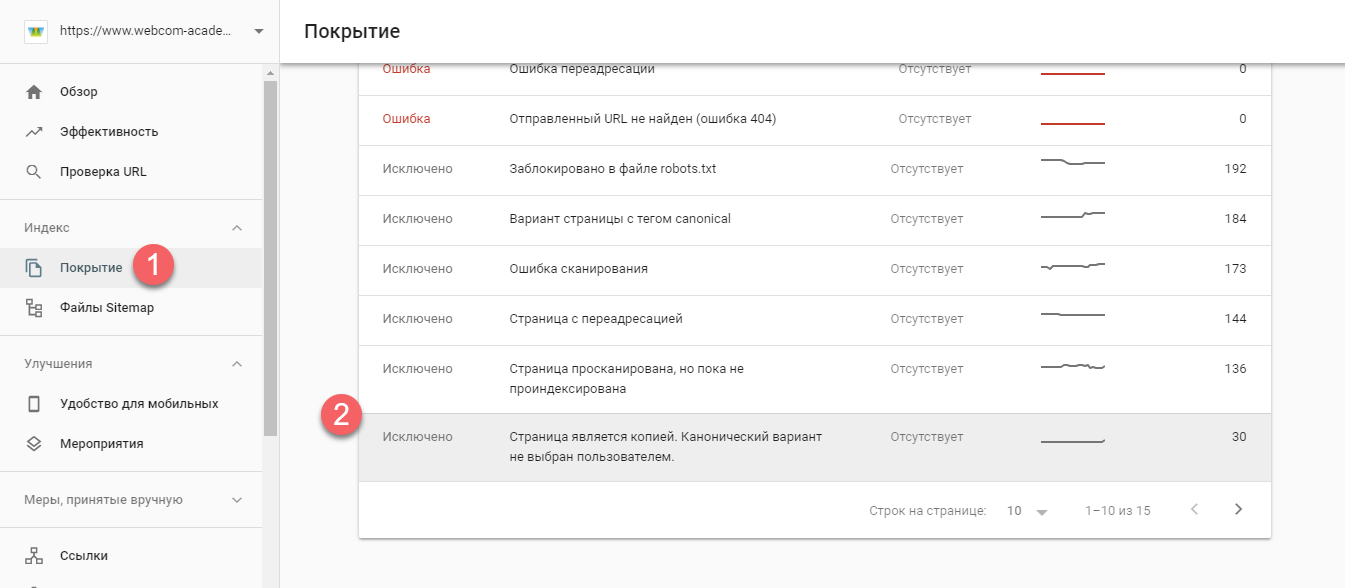

Причина номер 5. Некорректно настроенный атрибут rel=canonical.

Если rel каноникал настроен на другую страницу, то вы говорите поисковому роботу о том, что она схожа с другой станицей и первую страницу не нужно добавлять в индекс поисковых систем.

Также это можно увидеть в вебмастере Яндекс («Страницы в поиске»- «Исключенные страницы». Проверять необходимо статус «неканонические»).

Причина номер 6. Проблемы с ответом сервера

Для того, чтобы страница индексировалась, ее код ответа сервера должен быть 200 ОК. Если страница отдает ответ сервера 404 или 301, в индекс поисковых систем данная страница не попадет.

Проверять код ответа лучше всего с помощью вебмастеров, они показывают наиболее точные данные. А вот визуальной проверкой лучше не ограничиваться, так как бывают случаи, когда страницы выглядят корректно, но код ответа сервера не 200.

Причина номер 7. Проблемы с хостингом или сервером

Представьте, вы приходите в магазин, а он не работает. Потом снова приходите в магазин, но он все равно не работает. Какова вероятность того, что вы вернетесь туда? Вероятнее всего очень маленькая.

Тоже самое происходит и с поисковыми системами. Если он приходит на ваш сайт, а он не работает, то робот просто исключает страницы из индекса и не показывает их пользователям.

Правильно, зачем пользователей приводить на неработающий сайт.

Для того, чтобы отследить есть ли проблема, необходимо в вебмастерах проверять статус страниц. Если встречаются ошибки сервера 5хх (500, 503), а также если вам приходят уведомления из Яндекс.Метрики о том, что сайт не работает, необходимо решать данную проблему.

Причина номер 8. Проблемы со скоростью загрузки страниц

Как проверить? Начните с инструмента PageSpeed Insights от Google. Дополнительно можете использовать сервисы Google Аналитика и Яндекс.Метрика.

Совет! Важно проверять скорость загрузки для нескольких типов страниц и не останавливаться выполнив только одну проверку, т.е. выполнять данные работы периодически.

Причина номер 9. Проблема с уникальностью и полезностью контента

Поисковики уделяют большое внимание качеству контента, поэтому, если на странице расположен не полезный контент, либо же дублирующийся с другими страницами, такие страницы не добавляются в индекс поисковых систем.

Причина номер 10. Проблемы с AJAX

Если ваш сайт выполнен на технологии AJAX очень важно правильно выполнить требования поисковых систем, для того чтобы поисковые роботы смогли проиндексировать страницы вашего сайта.

Таким образом для каждой отдельной страницы должна быть своя HTML-версия.

И напоследок, дадим вам несколько советов, как ускорить индексацию:

Также смотрите наш видеоролик https://youtu.be/HF-2dd4luQY с помощью которого вы сможете найти ошибки у себя на сайте и запланировать работы по их исправлению.

Если вы хотите продвинуть свой сайт в ТОП поисковой выдачи, тогда записывайтесь на курс по SEO-продвижению

Страница обходится роботом, но отсутствует в поиске в я.вебмастере. Как победить?

На сайте 50 тысяч страниц. Контент этих страниц спарсен и обновляется с открытых источников, структурирован для всевозможных поисков и вообще юзерам удобно. Тексты на страницах разные, на выходе получаются уникальными.

Как было пару месяцев назад:

— 5-10% страниц улетали сразу после первичного обхода роботом как недостаточно качественные (это ОК и не проблема);

— остальные страницы почти моментально залетали в индекс и в выдаче ссылки на сайт были с ярлычком «1 час назад», приятно радовало.

Что есть сейчас:

— небольшая часть страниц все так же улетает как некачественная (это ОК);

— 40% страниц залетает в индекс, но уже не так быстро, как раньше. В основном нахожу свои страницы в выдаче с пометкой «вчера» или «позавчера»;

— оставшаяся часть страниц висит в вебмастере со статусом «Страница обходится роботом, но отсутствует в поиске.» и в выдаче, понятно, отсутствует.

Вот с последней частью страниц у меня есть недопонимание: никакой доп инфы кроме «ответ сервера 200 ОК» и даты первого обхода для таких страниц не отображается.

Эти страницы висят неделями без изменения статуса. При этом в исключенных страницах в вебмастере они отсутствуют, зато присутствуют в страницах, которые робот обошел и скушал. И без единой ошибки, стоят в списке наравне с успешно проиндексированными и представленными в поиске.

Есть мнение, что если решить вопрос №1, то вопрос №2 самоликвидируется.

Страница неизвестна роботу яндекса что делать

У меня несколько сайтов различного уровня и тематики.

В последний месяц столкнулся с проблемой слабой индексации новых статей.

Уникальный контент хорошо отформатированный от 2 до 3 тыс. символов, не переспамленный, копипластерами не сворованный.

При проверке через вебмастер выдает:

«Страница обходится роботом, но отсутствует в поиске»

Причем старые статьи не выпадают, это касается именной новых статей опубликованных за последние два месяца. Раньше всё было нормально.

2. Изменял форматирование, уровень вложенности, удалял внутренние ссылки на тех страницах где они были, делал перелинковку, добавлял уникальные фото. Положительной тенденции не заметил и пока не обнаружил какую-то взаимосвязь с общеизвестными факторами ранжирования.

Эксперименты проводил на 12-ти сайтах, на каждом публикуются от 5 до 100 статей в месяц, различной тематики и различными авторами. Слабая индексация меня тревожит и я не понимаю в каком направлении двигаться дальше.

Кто-нибудь сталкивался с этой проблемой?

Я сталкивался. Уже пол года 3к станиц вместо 20к у ИМ.

Платоны говорят следующее:

Спасибо за примеры. Мы проверили, Ваш сайт присутствует в поиске и находится пользователями, но некоторые его страницы действительно отсутствуют в выдаче, при этом никаких санкций на них не наложено. Дело в том, что наши алгоритмы устроены так, чтобы на запросы пользователей давать наиболее полный ответ, и в связи с этим в поисковую базу попадают наиболее релевантные документы ( http://help.yandex.ru/webmaster/yandex-indexing/excluded-pages.xml ).

В то же время наш робот помнит о других страницах сайта: если на них присутствуют ссылки, он периодически посещает их, и со временем они также могут быть включены в поиск. Однако гарантировать это мы не можем, поскольку решение принимается механизмами, которые действуют полностью автоматически.

Продолжайте работать над развитием Вашего ресурса бла бла бла.

Пока у меня только одна версия:

Яндекс не добавляет страницу в индекс пока по ней не будут зафиксированы переходы пользователей по внутренним или внешним ссылкам, т.е. если статью никто ни разу не прочитал, то зачем она нужна.

Других вариантов объяснения я не нашел.

Да тут полфорума с такой же проблемой. Общего решения пока нет.

У меня переходят на эти страницы, но их по прежнему нет в поиске.

Покажешь пациентов в личку?

коллега по несчастью 🙂

Чем больше активность на страничках, тем больше вероятность, что они попадут и останутся в индексе. Хотя какой-то четкой зависимости я не заметил.

Кстати я в это не верил, но на другой CMS тот же товар с теме же фотками и характеристиками лез на ура, по 3-4к страниц за апдейт.

Но из-за нюансов загрузки товара не можем использовать её.

Знакомая ситуация, такая же штука есть на сайте + каждый Ап выпадают страницу, а залетает 1-2 новых.

Аналогичная ситуация на белых и серых проектах. Во всех случаях контент чистый, оригинальный. На одном сайте материал/раздел не лезет в индекс ни под каким предлогом. На другом (равном) этот же материал на ура попадает в индекс с быстророботом и держится стабильно. И наоборот. Танцы с бубном не помогают. Вероятно, вправду «особенности алгоритмов.» 🍿

может быть они какой то порог конкуренции поставили.

по типу есть 500 страниц по 1 запросу, все больше не добавляют.

с такой же проблемой столкнулся

собрал около 1к ключей прогнал через мутаген и взял самые низкоконкурентные, все новые страницы удачно вошли.

Набор слов по корпусу и пассажи, скорее всего, уже есть в выдаче и Яндекс не видит, какую иную информацию страница может предоставить. Введите в контент пяток редких тематических слов, которых нет в выдаче или прилепите к документу пару инфографиков или видео какое, т е сделайте его отлИчным.